В нашей повседневной жизни мы часто слышим слово БОТ. В нашей голове этот термин ассоциируются со злыми, вредоносныит ботами, которые сегодня представляют собой большую угрозу для всех, кто пользуется благами Интернета.

В нашем материале мы расскажем о хороших, полезных ботах, призванных облегчить жизнь интернет-пользователям, а именно на ботах индексации – поисковых роботах, которые также называются веб-роботами, пауками, веб-краулерами и веб-бродилками. Какие же действия выполняют эти автоматизированные программы?

В данной статье речь пойдет о:

Поисковые роботы

Поисковые роботы — это программы, осуществляющие автоматизированный мониторинг Интернета с целью каталогизации его содержимого. Они были созданы в первую очередь для поддержки работы поисковых сервисов (таких как Google, Bing или Yandex), которые используют краулеры для правильного индексирования сайтов, чтобы пользователи могли быстро находить интересующие их страницы.

Без этого поисковик был бы устаревшим — он не знал бы об изменениях, произошедших на конкретном сайте, или о новом содержимом, появившемся на нем. Поэтому основными функциями веб-роботов являются проверка кода и изучение содержимого веб-страниц, мониторинг обновлений, создание зеркал страниц, а иногда и сбор дополнительной информации о данном сайте. Именно усердная работа пауков позволяет ранжировать страницы в результатах поисковых систем.

Какие самые известные поисковые роботы?

Существуют сотни более или менее известных веб-роботов. Некоторые из них являются постоянными посетителями почти всех сайтов. Наиболее популярными веб-ботами являются:

- GoogleBot,

- YandexBot,

- Bingbot,

- Slurp Bot,

- DuckDuckBot,

- Baiduspider,

- Sogou Spider,

- Exabot,

- FaceBOT,

- ia_archiver.

GoogleBot

Бот, используемый Google – GoogleBot. Можно разделить на «свежие боты Google», которые часто и регулярно посещают сайты, чтобы посмотреть, что на них изменилось, и «глубокие боты Google», задача которых — получить больше данных с сайтов.

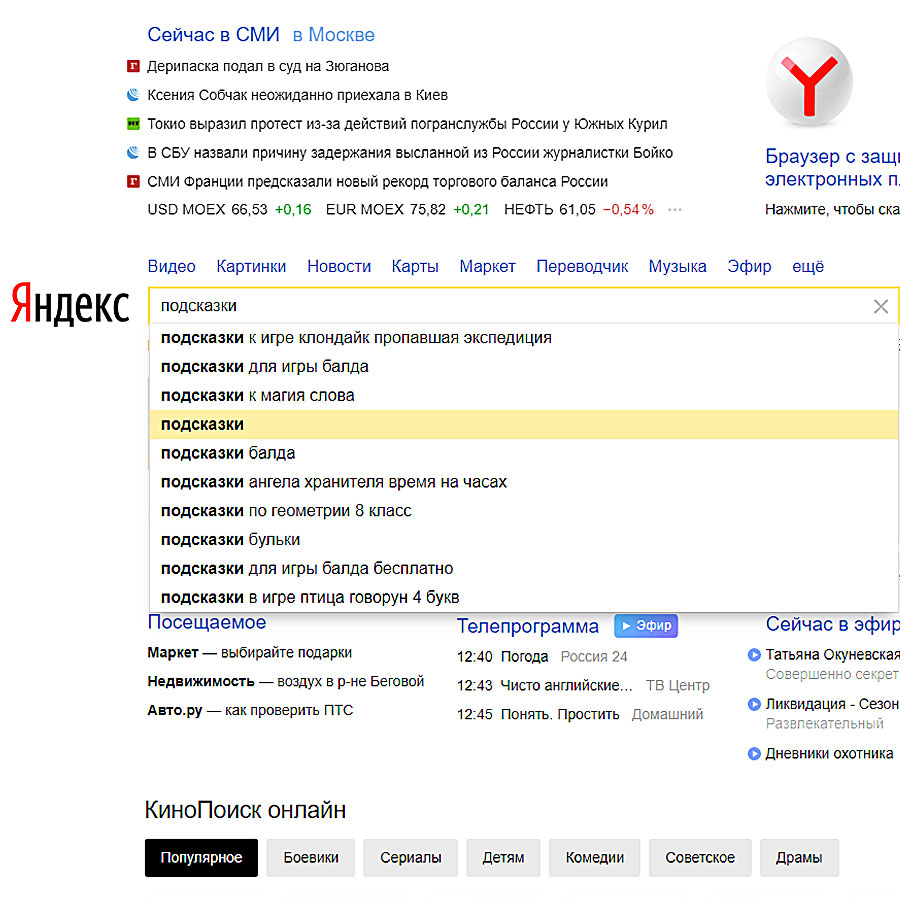

YandexBot

Веб-робот крупнейшей в России поисковой системы Яндекс.

Bingbot

Веб-робот Bingbot поисковой системы Bing, внедренный компанией Microsoft в 2010 году.

Slurp Bot

Slurp Bot, новая версия Yahoo Slurp — паука, используемого поисковой системой Yahoo. Изучение сайта этим ботом позволяет сайту появиться в результатах поиска Yahoo Mobile. Кроме того, Slurp проверяет и собирает контент с партнерских сайтов для включения в Yahoo News, Yahoo Finance и Yahoo Sports.

DuckDuckBot

Веб-робот поисковой системы DuckDuckGo, которая известна своей защитой конфиденциальности и набирает все большую популярность. В настоящее время он обрабатывает более 12 миллионов запросов в день.

Baiduspider

Baiduspider — это официальное название индексирующего бота китайской поисковой системы Baidu, ведущей китайской поисковой системы с 80% долей всего рынка поисковых систем в материковом Китае.

Sogou Spider

Sogou Spider — BOT, работающий на Sogou.com, китайской поисковой системе, которая была запущена в 2004 году.

Exabot

Веб-робот французской поисковой системы Exalead. Он был создан в 2000 году и в настоящее время насчитывает более 16 миллиардов проиндексированных страниц.

FaceBOT

Бот Facebook FaceBOT может временно отображать определенные изображения или детали, связанные с веб-контентом — например, заголовок страницы или тег встраивания видео, — которыми пользователи Facebook хотят поделиться.

FaceBOT получает эту информацию только тогда, когда пользователь предоставляет ссылку. Кроме того, он предназначен для повышения эффективности рекламы.

ia_archiver

ia_archiver — робот, индексирующий онлайн-рейтинги Alexa от Amazon.

Конечно, помимо тех, что работают на интернет-гигантов, существуют и другие типы веб-ботов. Например, Xenon — это веб-робот, используемый государственными налоговыми органами Нидерландов, Австрии, Канады, Дании, Великобритании и Швеции для поиска веб-сайтов (интернет-магазинов, сайтов азартных игр или порносайтов), владельцы которых уклоняются от уплаты налогов, а WebCrawler использовался для создания первого общедоступного индекса подмножества Всемирной паутины.

Как работает поисковый бот?

Веб-роботы получают или сами создают списки URL-адресов для посещения, называемые семенами. Когда бот посещает эти URL, он ищет все гиперссылки на данном сайте и добавляет их в список URL для посещения, называемый границей индексации.

Если, кроме того, в его задачи входит архивирование страниц — он копирует и сохраняет данные по ходу работы. Архив, называемый хранилищем, содержит последнюю версию данной страницы, загруженную индексирующим роботом. Конечно, такое большое количество страниц означает, что поисковая система может получить только ограниченное количество информации за определенное время — поэтому ей приходится создавать иерархию посещений.

Что делает робот на сайте?

Как только паук выбрал страницу, которую он хочет посетить, он идентифицирует себя для веб-сервера с помощью заголовка User-Agent в HTTP-запросе со своим собственным уникальным идентификатором. В большинстве случаев трафик робота-индексатора можно просмотреть в журналах referrer-страниц веб-сервера.

Затем бот собирает информацию о рассматриваемой странице, такую как содержащийся на ней контент, ссылки, неработающие ссылки, карты сайта и проверка HTML-кода, следуя правилам, установленным владельцем страницы.

Можно ли избежать посещения сайта краулерами?

Иногда может случиться так, что индексирующие роботы постоянно запрашивают сайт, что может вызвать проблемы с загрузкой страницы. Чтобы избежать такой ситуации, администратор конкретного сайта может указать правила, которым должен подчиняться Internet бот на его сайте — с помощью файла robots.txt. Это решение было предложено в феврале 1994 года Мартином Костером, работавшим в компании Nexor, на дискуссионном форуме www-talk и быстро стало тем, чего ожидали от нынешних и будущих веб-роботов.

Текущая же версия появилась благодаря компании Google, которая 1 июля 2019 года объявила свой протокол исключения роботов или robot.txt официальным стандартом в рамках рабочей группы по разработке Интернета.

Поместив соответствующим образом измененный файл robots.txt в корневой каталог иерархии вашего сайта (например, https://www.example.com/robots.txt), вы можете определить правила для индексирующих роботов, такие как URL-адреса, которые им разрешено посещать и к которым им запрещено обращаться, разрешение или блокирование определенных ресурсов для индексации и т.д. Веб-боты должны следовать правилам, определенным в этом файле — они должны загрузить этот файл и прочитать инструкции, прежде чем загружать любые другие данные с сайта.

Вы также можете указать, должны ли эти правила применяться ко всем ботам или к тем, которые имеют определенный User-Agent. Если файл robot.txt не существует, веб-роботы предполагают, что владелец сайта не хочет накладывать на них никаких ограничений.